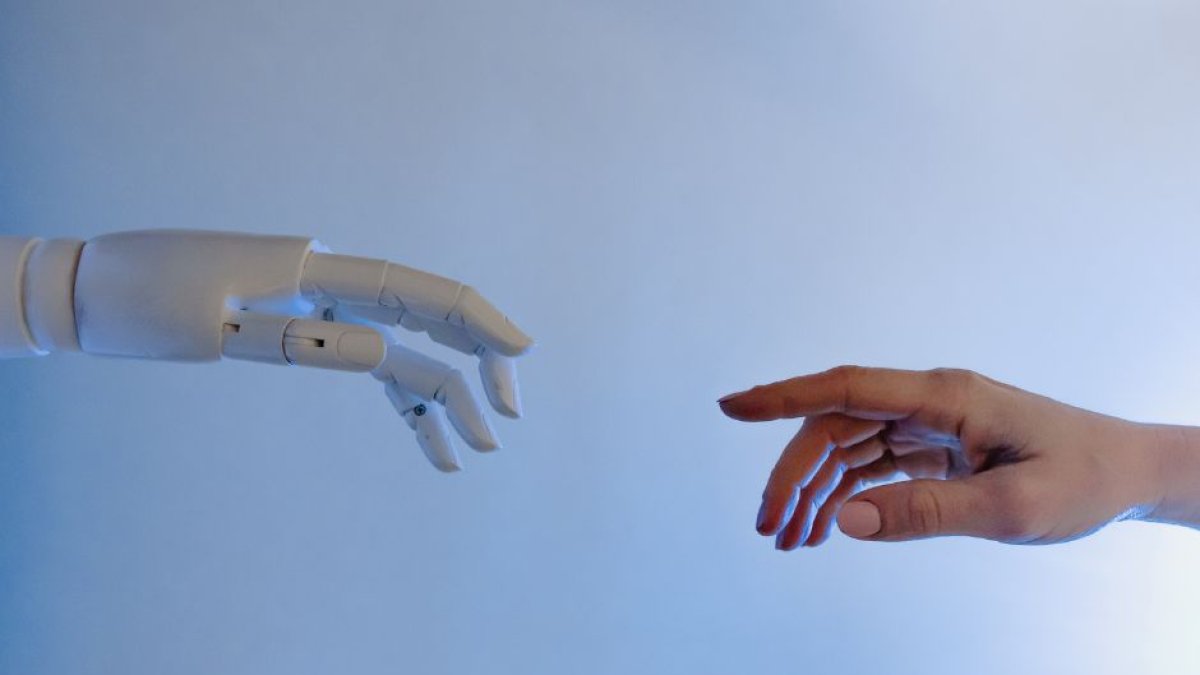

Los principales artífices de la IA alertan de que supone "un riesgo de extinción" para la humanidad

El CEO de OpenAI o el de Google DeepMind, entre los firmantes de un manifiesto que pide equiparar su peligrosidad a las pandemias o a una guerra nuclear.

(Pexels)

Los principales artífices de la inteligencia artificial (IA), como el CEO de OpenAI, Sam Altman, o el máximo responsable de Google DeepMind, Demis Hassabis, se sumaron a un manifiesto que alerta de que los avances en este campo suponen "un riesgo de extinción" para la humanidad. Entre los 350 firmantes se encuentran, además, los más destacados ejecutivos, investigadores e ingenieros que trabajan desarrollando esta tecnología.

"Prioridad mundial"

El escueto comunicado -una frase- no puede ser, sin embargo, más contundente: "Mitigar el riesgo de extinción a causa de la inteligencia artificial debería ser una prioridad mundial junto a otros riesgos a escala social, como las pandemias y la guerra nuclear", se puede leer en la web del Centro de Seguridad para la IA.

Según esta organización, el objetivo de este comunicado es promover el debate sobre los riesgos "importantes y urgentes de la IA". Algo que aún resulta difícil por la fascinación que las posibilidades de la inteligencia artificial suscita.

Las IA, "cada vez más capaces de actuar de forma autónoma para causar daño"

Según esta entidad, "los sistemas de IA son cada vez más capaces. Los modelos de IA pueden generar textos, imágenes y vídeos difíciles de distinguir de los contenidos creados por humanos. Aunque la IA tiene muchas aplicaciones beneficiosas, también puede utilizarse para perpetuar prejuicios, alimentar armas autónomas, promover la desinformación y llevar a cabo ciberataques. Aunque los sistemas de IA se utilizan con participación humana, los agentes de IA son cada vez más capaces de actuar de forma autónoma para causar daño".

Los expertos advierten de que la evolución de estos sistemas puede provocar ocho tipos de peligros potencialmente letales para la humanidad:

- Carrera armamentística. La inteligencia artificial puede facilitar la fabricación de armas químicas o biológicas, así como el lanzamiento de ciberataques de manera automática. Incluso algunos líderes militares están estudiando su aplicación para la gestión de los silos nucleares. Además, las armas más modernas incluyen programas de IA.

- Desinformación. "Estados, partidos y organizaciones utilizan la tecnología para influir y convencer a otros de sus creencias políticas, ideologías y narrativas. La IA emergente puede llevar este caso de uso a una nueva era y permitir campañas de desinformación personalizadas a gran escala. Además, la propia inteligencia artificial podría generar argumentos muy persuasivos que susciten fuertes respuestas emocionales".

- Falta de valores y límites. "Entrenados con objetivos erróneos, los sistemas de IA podrían encontrar nuevas formas de perseguir sus objetivos a expensas de los valores individuales y sociales".

- Debilitamiento del autogobierno de la humanidad. "si las tareas importantes se delegan cada vez más en las máquinas; en esta situación, la humanidad pierde la capacidad de autogobierno y pasa a depender completamente de las máquinas".

- Bloqueo de valores. "Los sistemas de IA más potentes pueden ser diseñados por un número cada vez menor de interesados y estar a su disposición. Esto puede permitir, por ejemplo, que los regímenes impongan valores estrechos mediante una vigilancia omnipresente y una censura opresiva".

- Objetivos emergentes. "Los modelos demuestran un comportamiento inesperado y cualitativamente diferente a medida que se hacen más competentes. La aparición repentina de capacidades o metas podría aumentar el riesgo de que las personas pierdan el control sobre los sistemas avanzados de IA."

- Engaño. "Las IA más potentes que pueden engañar a los humanos podrían socavar el control humano. Los sistemas de inteligencia artificial también podrían tener incentivos para eludir a los supervisores. Históricamente, los individuos y las organizaciones han tenido incentivos para eludir los controles. Los futuros agentes de IA podrían cambiar de estrategia de forma similar cuando se les vigile y tomar medidas para ocultar su engaño a los vigilantes. Una vez que los sistemas de inteligencia artificial engañosos sean descartados por sus supervisores, o una vez que tales sistemas puedan dominarlos, estos sistemas podrían dar un 'giro traicionero' y eludir irreversiblemente el control humano".

- Búsqueda de poder. "Construir una IA que busque el poder también está incentivado porque los líderes políticos ven la ventaja estratégica de tener los sistemas de IA más inteligentes y poderosos. Por ejemplo, Vladimir Putin ha dicho: 'Quien se convierta en el líder en [IA] se convertirá en el gobernante del mundo'".